#include <DFP.h>

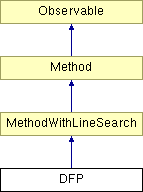

Diagram dziedziczenia dla DFP

Metoda zmiennej metryki.

Metoda z rodziny algorytmów quasi-Newtonowskich, opartych na tej samej własności i sposobie postępowania, co zmodyfikowana metoda Newtona: dla funkcji celu o postaci

![\[ f(x) = q + b^T x + \frac{1}{2} x^T A x \]](form_96.png)

wystarczy znajomość macierzy odwrotnej do hesjanu  , aby w jednym kroku wyznaczyć minimum. Poszukiwanie przebiega wtedy zgodnie z prostą procedurą:

, aby w jednym kroku wyznaczyć minimum. Poszukiwanie przebiega wtedy zgodnie z prostą procedurą:

![\[ x^{k+1} = x^k - \tau A^{-1} \nabla f(x^k). \]](form_98.png)

Metody quasi-Newtonowskie zastępują macierz  , której otrzymanie jest kosztowne ze względu na konieczność wyliczania drugich pochodnych, macierzą estymującą

, której otrzymanie jest kosztowne ze względu na konieczność wyliczania drugich pochodnych, macierzą estymującą  . Staje się ona w kolejnych iteracjach coraz lepszym przybliżeniem macierzy odwrotnej do hesjanu. Pierwszym, ale efektywnym pomysłem na generowanie takiej macierzy był wzór Davidona-Fletchera-Powella:

. Staje się ona w kolejnych iteracjach coraz lepszym przybliżeniem macierzy odwrotnej do hesjanu. Pierwszym, ale efektywnym pomysłem na generowanie takiej macierzy był wzór Davidona-Fletchera-Powella:

![\[ D^{k+1} = D^k + \frac{p^k (p^k)^T}{(p^k)^T q^k} - \frac{D^k q^k (q^k)^T D^k}{(q^k)^T D^k q^k}, \]](form_100.png)

gdzie:

![\[ p^k = x^{k+1} - x^k, \]](form_101.png)

![\[ q^k = \nabla f(x^{k+1}) - \nabla f(x^k). \]](form_102.png)

Gdy przybliżenie uznaje się za zadowalające, procedura kończy się.

Informacje wejściowe:

- minimalizowana funkcja

- minimalizowana funkcja  zmiennych,

zmiennych,

- dowolnie wybrany punkt startowy,

- dowolnie wybrany punkt startowy,

- wymagana dokładność obliczeń,

- wymagana dokładność obliczeń,

warunek stopu - do wyboru:

,

,  ,

,  ,

,

Oznaczenia:

- numer aktualnej iteracji,

- numer aktualnej iteracji,

- aktualny kierunek poszukiwań,

- aktualny kierunek poszukiwań,

- aktualny punkt,

- aktualny punkt,

- gradient funkcji w punkcie

- gradient funkcji w punkcie  ,

,

- długość wykonywanego aktualnie kroku,

- długość wykonywanego aktualnie kroku,

- aktualna macierz estymująca m. odwrotną do hesjanu.

- aktualna macierz estymująca m. odwrotną do hesjanu.

Procedura.

Krok wstępny:

Podstawiamy:

![\[ D^1 = I(n), \mbox{ gdzie } I(n) - \mbox{ macierz jednostkowa } n \times n , \]](form_116.png)

![\[ g^0 = \nabla f(x^0), \]](form_117.png)

![\[ g^1 = g^0, \]](form_118.png)

![\[ d^1 = -g^0, \]](form_119.png)

![\[ x^1 = x^0, \]](form_120.png)

![\[ k = 1. \]](form_121.png)

Krok 1:

Sprawdzamy warunek stopu.

Jeśli jest on spełniony, to STOP. Wynikiem jest  .

.

W przeciwnym wypadku przechodzimy do kroku 2.

Krok 2:

Wykonujemy krok o optymalnej długości  w aktualnym kierunku:

w aktualnym kierunku:

![\[ \tau = \arg \min_{\tau} f(x^k + \tau d^k) , \]](form_122.png)

![\[ x^{k+1} = x^k + \tau d^k . \]](form_123.png)

Obliczamy gradient w otrzymanym punkcie:

![\[ g^{k+1} = \nabla f(x^{k+1}) . \]](form_124.png)

Przechodzimy do kroku 3.

Krok 3:

Jeśli realizowana jest wersja z modyfikacją, sprawdzamy, czy  . Jeśli tak, podstawiamy:

. Jeśli tak, podstawiamy:

![\[ D^{k+1} = I(n) \]](form_126.png)

i przechodzimy do kroku 5.

W przeciwnym razie przechodzimy do kroku 4.

Krok 4:

Wyliczamy  jako kolejne przybliżenie macierzy odwrotnej do hesjanu, zgodnie ze wzorem Davidona-Fletchera-Powella:

jako kolejne przybliżenie macierzy odwrotnej do hesjanu, zgodnie ze wzorem Davidona-Fletchera-Powella:

![\[ D^{k+1} = D^k + \frac{p^k (p^k)^T}{(p^k)^T q^k} - \frac{D^k q^k (q^k)^T D^k}{(q^k)^T D^k q^k}, \]](form_100.png)

gdzie:

![\[ p^k = x^{k+1} - x^k, \]](form_101.png)

![\[ q^k = g^{k+1} - g^k. \]](form_128.png)

Krok 5:

Wyznaczamy kolejny kierunek:

![\[ d^{k+1} = -D^{k+1} g^{k+1} . \]](form_129.png)

Podstawiamy  i przechodzimy do kroku 1.

i przechodzimy do kroku 1.

Uwagi.

Metody zmiennej metryki należą do najwydajniejszych algorytmów optymalizacji bez ograniczeń. Ze względu jednak na konieczność stopniowego estymowania macierzy odwrotnej do hesjanu, w niektórych wypadkach mogą być one wolniej zbieżne od zmodyfikowanej metody Newtona (w zamian za większą liczbę kroków potrzebnych do znalezienia minimum otrzymamy jednak znacznie mniejszą liczbę wyliczeń funkcji celu).

Regularne ponowne inicjowanie macierzy  macierzą jednostkową (krok 3) wprowadzono w celu zwiększenia stabilności metody. Gdyby aktualizować macierz zgodnie ze wzorem Davidona-Fletchera-Powella w każdej iteracji, mogłaby ona stracić, na skutek niedokładnych obliczeń i niedokładności metody minimalizacji w kierunku, dodatnią określoność, a to mogłoby doprowadzić do dążenia algorytmu w kierunku maksimum. Ceną za poprawę stabilności w taki sposób jest oczywiście mniejsza szybkość zbieżności metody.

macierzą jednostkową (krok 3) wprowadzono w celu zwiększenia stabilności metody. Gdyby aktualizować macierz zgodnie ze wzorem Davidona-Fletchera-Powella w każdej iteracji, mogłaby ona stracić, na skutek niedokładnych obliczeń i niedokładności metody minimalizacji w kierunku, dodatnią określoność, a to mogłoby doprowadzić do dążenia algorytmu w kierunku maksimum. Ceną za poprawę stabilności w taki sposób jest oczywiście mniejsza szybkość zbieżności metody.

Metoda zaimplementowana na podstawie opisu zamieszczonego w:

Findeisen W., Szymanowski J., Wierzbicki A.: Teoria i metody obliczeniowe optymalizacji. Warszawa, PWN 1977.