#include <HookeJeevesDiscrete.h>

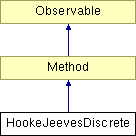

Diagram dziedziczenia dla HookeJeevesDiscrete

Metoda poszukiwań prostych.

Metoda wyznacza kierunek za pomocą kroków próbnych wzdłuż osi, a następnie wykonuje krok roboczy w tym kierunku. Jeśli w nowym punkcie, za pomocą kolejnych kroków próbnych, uda się wyznaczyć kierunek opadania funkcji, wykonywany jest kolejny krok roboczy. Jeśli nie, to długość kroku próbnego ( ) jest zmniejszana (mnożona razy współczynnik

) jest zmniejszana (mnożona razy współczynnik  ).

).

Algorytm kończy się w momencie, gdy długość kroku staje się mniejsza niż parametr epsilon lub przekroczona zostaje dozwolona liczba iteracji.

Informacje wejściowe:

- minimalizowana funkcja

- minimalizowana funkcja  zmiennych,

zmiennych,

- dowolnie wybrany punkt startowy,

- dowolnie wybrany punkt startowy,

: - długość kroku próbnego,

: - długość kroku próbnego,

- współczynnik skracania kroku (

- współczynnik skracania kroku ( ),

),

- warunek stopu - minimalna długość kroku próbnego.

- warunek stopu - minimalna długość kroku próbnego.

Oznaczenia:

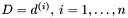

- indeks aktualnego kierunku,

- indeks aktualnego kierunku,

- numer aktualnej iteracji,

- numer aktualnej iteracji,

- aktualna baza kierunków,

- aktualna baza kierunków,

- aktualny punkt próbny,

- aktualny punkt próbny,

- najlepszy punkt w k-tym etapie,

- najlepszy punkt w k-tym etapie,

- wartość funkcji w punkcie

- wartość funkcji w punkcie  ,

,

- punkt bazowy dla kroków próbnych w k-tym etapie,

- punkt bazowy dla kroków próbnych w k-tym etapie,

- wartość funkcji w punkcie

- wartość funkcji w punkcie  .

.

Procedura.

Krok wstępny:

Podstawiamy:

![\[ D = I(n), \mbox{ gdzie } I(n) - \mbox{ macierz jednostkowa } n \times n , \]](form_213.png)

![\[ x^1_{min} = x^0, \]](form_214.png)

![\[ F^1_{min} = f(x^0) , \]](form_215.png)

![\[ x_b^1 = x^0, \]](form_216.png)

![\[ F_b^1 = f(x^0) , \]](form_217.png)

![\[ k = 1 , \]](form_218.png)

![\[ i = 1 . \]](form_219.png)

Krok 1:

Badamy wartość funkcji w nowym punkcie próbnym po wykonaniu kroku w i-tym kierunku (wzdłuż i-tej osi):

![\[ x^i = x^k_{min} + \tau d^{(i)} . \]](form_220.png)

Jeśli krok był udany ( ), to zapamiętujemy punkt próbny jako najlepszy:

), to zapamiętujemy punkt próbny jako najlepszy:

![\[ x^k_{min} = x^i, \]](form_222.png)

![\[ F^k_{min} = f(x^i), \]](form_223.png)

a następnie przechodzimy do kroku 3.

W przeciwnym wypadku ( ) przechodzimy do kroku 2.

) przechodzimy do kroku 2.

Krok 2:

Wykonujemy krok próbny w przeciwnym kierunku:

![\[ x^i = x^k_{min} - \tau d^{(i)} . \]](form_225.png)

Jeśli krok był udany ( ), to zapamiętujemy punkt próbny jako najlepszy:

), to zapamiętujemy punkt próbny jako najlepszy:

![\[ x^k_{min} = x^i, \]](form_222.png)

![\[ F^k_{min} = f(x^i). \]](form_226.png)

Przechodzimy do kroku 3.

Krok 3:

Sprawdzamy, czy wykonano kroki próbne we wszystkich kierunkach:

Jeśli  , podstawiamy

, podstawiamy  i ponownie przechodzimy do kroku 1.

i ponownie przechodzimy do kroku 1.

Jeśli  , przechodzimy do kroku 4.

, przechodzimy do kroku 4.

Krok 4:

Sprawdzamy, czy przy ostatnim przeszukiwaniu  kierunków nastąpiła poprawa:

kierunków nastąpiła poprawa:

Jeśli tak ( ), to przechodzimy do kroku 5.

), to przechodzimy do kroku 5.

W przeciwnym razie przechodzimy do kroku 6.

Krok 5:

Zapamiętujemy aktualny punkt jako punkt bazowy dla następnego etapu:

![\[ x_b^{k+1} = x^k_{min}. \]](form_231.png)

Następnie wykonujemy krok roboczy w znalezionym w tym etapie kierunku opadania funkcji:

![\[ x^{k+1}_{min} = x^k_{min} + (x^k_{min} - x^k_b). \]](form_232.png)

Przechodzimy do kroku 7.

Krok 6:

Skracamy długość kroku próbnego:

![\[ \tau = \beta \tau \]](form_233.png)

i cofamy się do punktu bazowego:

![\[ x^{k+1}_{min} = x^k_b. \]](form_234.png)

Przechodzimy do kroku 7.

Krok 7:

Sprawdzamy warunek stopu:

Jeśli  , kończymy działanie. Wynikiem jest

, kończymy działanie. Wynikiem jest  .

.

W przeciwnym wypadku podstawiamy  ,

,  i przechodzimy do kroku 1.

i przechodzimy do kroku 1.

Uwagi.

Metoda zaimplementowana na podstawie programu Marka G. Johnsona (http://www.netlib.org/opt/hooke.c), który powstał na podstawie pseudokodu z "Algorithm 178: Direct Search" Arthura F. Kaupe Jr. i zawiera poprawki Bella i Pike'a (CACM v.9, str. 684, Wrzesień 1966) oraz Tomlina i Smitha ("Remark on Algorithm 178", CACM v.12).

Długość kroków próbnych nie jest zależna od pozycji punktu startowego, w przeciwieństwie do implementacji Johnsona.